Seiten aus Google löschen: So sperren und entfernen Sie Inhalte

Nicht immer möchten Websitebetreiber alle Inhalte der eigenen Website bei Google & Co. such- und auffindbar machen. Aber wie können Besitzer einer Website Inhalte aus Google löschen oder Seiten für Google sperren? Und warum überhaupt?

Ein Fachartikel von Markus Hövener

Die Webcrawler, auch Spider oder Robot genannt, von Google & Co. sind nicht unbedingt selektiv beim Indexieren einer Website: Sie starten häufig auf der Startseite einer Website und folgen fast allen Links, die sie hier finden. Beim crawlen der einzelnen Seiten einer Internetpräsenz werden auch Inhalte erfasst, die für Suchmaschinen nicht relevant sind oder bei denen es nicht gewünscht ist, dass bestimmte Inhalte in den Suchergebnissen auftauchen. Solche Inhalte lassen sich sperren oder nachträglich löschen.

Gründe für das Sperren von Websites oder einer einzelnen Seite bei Google & Co.:

- Bei der Entwicklung oder dem Relaunch einer Website wird der Inhalt der neuen Website oft unter einer Test-Domain (z. B. test.meinewebsite.de) aufgebaut. Damit Google die neuen Inhalte in der Entwicklungsphase nicht indexiert, sperrt man derartige Websites in der Regel für Suchmaschinen.

- Es kann sein, dass es auf einer Website bestimmte Inhalte gibt, die für Suchmaschinen nicht relevant sind (z. B. Traffic-Auswertungen). Falls diese nicht durch einen Login geschützt sind, sollten diese gesperrt werden.

- Auf manchen Websites gibt es Inhalte in doppelter Form: als HTML-Datei und als PDF-Datei. In diesem Fall kann man dann die PDF-Dateien für Crawler sperren, um doppelten Content zu vermeiden.

Vorteile für das Sperren von Inhalten:

- Wenn Google viele irrelevante Inhalte abholt, bindet das die „Crawler-Energie“ der Suchmaschine. Ein Crawler kann pro Tag nur eine bestimmte Menge an Daten indexieren. Und auch der Platz im Index ist beschränkt. Wer den Index also mit irrelevanten Daten „flutet“, hat weniger Chancen darauf, seine wirklich wichtigen Inhalte zeitnah in den Index zu bekommen.

- Die letzten Updates von Google haben gezeigt, dass die Suchmaschine durchaus alle Seiten einer Website bewertet. Wer dann viele irrelevante Inhalte hat, läuft Gefahr eine schlechte Gesamtbewertung und damit schlechte Rankings für seine Inhalte zu bekommen.

- Auch doppelter Inhalt (engl. duplicate content) kann Probleme bescheren, wenn auch nicht in Form einer Abstrafung, wie es oft vermutet wird. Aber wenn z. B. alle Inhalte als HTML- und gleichzeitig als PDF-Datei angeboten werden, ist es möglich, dass die Suchmaschinen die PDF-Dateien in den Suchergebnissen auflisten. Das bringt dann oft eine schlechte Nutzer-Erfahrung, schlägt sich aber auch in den Traffic-Zahlen nieder, denn viele Web-Analyse-Dienste erfassen einen PDF-Download nicht.

In vielen Fällen ist es also sinnvoll Inhalte zu sperren. Aber welche Möglichkeiten haben Websitebetreiber, Suchmaschinen und deren Webcrawler beim Indexieren einzuschränken? Und welche Möglichkeit nutzt man wann?

Inhalte über die robots.txt sperren

Seit 1994 können Websitebetreiber Inhalte über eine zentrale Datei für Suchmaschinen zu sperren, der robots.txt. Diese Textdatei befindet sich im Rootverzeichnis einer Website und kann über die URL http://www.meinewebsite.de/robots.txt abgerufen werden. Im Allgemeinen machen Suchmaschinen das vor dem Besuch einer Website als Erstes.

Auch wenn einige SEO-Tools das Fehlen einer robots.txt-Datei als Fehler anmerken, stimmt das sicherlich nicht. Denn sind keine Inhalte zu sperren, ist eine robots.txt unnötig. In jedem Fall sollte die robots.txt aber nur für das Sperren von Inhalten benutzt werden. Die Unsitte, diese Datei mit Suchbegriffen aufzufüllen, besteht zum Glück schon seit geraumer Zeit nicht mehr.

Es besteht über die Zeile „User-agent: …“ auch die Möglichkeit, verschiedenen Suchmaschinen unterschiedliche Sperrungen aufzugeben, sodass der Googlebot beispielsweise andere Inhalte sehen dürfte als der Webcrawler von Bing. In unserem Beispiel gelten die Sperrungen aber für alle Suchmaschinen („User-agent: *“).

Einige typische Einträge in der robots.txt-Datei lauten wie folgt:

- Alle Inhalte werden für alle Suchmaschinen gesperrt:

User-agent: *

Disallow: /

- Die Inhalte eines bestimmten Verzeichnisses werden gesperrt:

User-agent: *

Disallow: /info/

- Alle PDF-Dateien werden gesperrt:

User-agent: *

Disallow: /*.pdf

Eine gute Übersicht aller Spezifikationen zum Sperren von Inhalten über die robots.txt-Datei bietet Wikipedia. Dort sieht man auch, dass es neben den Anweisungen zum Sperren/Freigeben von Inhalten noch zwei weitere Angaben gibt, die grundsätzlich in dieser Datei platziert werden können:

- „Sitemap: URL“ – um die URL einer Sitemap-Datei an den Crawler zu übergeben

- „Crawl-delay: X“ – um den Crawler zu signalisieren, dass zwischen zwei Seitenabrufen X Sekunden gewartet werden soll

Inhalte über Robots-Meta-Tags sperren

Während die robots.txt die Sperren/Freigaben zentral speichert, werden mit dem Robots-Meta-Tag einzelne Webseiten gesperrt. Für Crawler ist dabei vor allem das Attribut „noindex“ interessant, das wie folgt notiert wird:

<meta name=„robots“ content=„noindex“>

Wenn Google & Co. nach dem crawlen einer Seite das „noindex”-Attribut findet, signalisiert das der Suchmaschine, dass diese Seite nicht in den Index übernommen werden soll. Mit diesem Tag ist es also möglich, Sperrungen für ganz konkrete Seiten vorzunehmen, ohne dass diese in der robots.txt-Datei aufgeführt werden müssen.

Neben dem „noindex”-Attribut gibt es noch weitere Anweisungen. Diese werden im Robots-Meta-Tag durch Kommata getrennt. (teilweise werden diese nur von Google korrekt interpretiert):

- nofollow: Folge keinen Links auf dieser Seite

- noarchive: Lege keinen Cache-Eintrag für diese Seite an

- nosnippet: Zeige kein Snippet (Textausschnitt) in den Suchergebnissen an

- noodp: Übernimmt keine Beschreibung aus dem ODP-/DMOZ-Verzeichnis als Snippet

- notranslate: Biete keine Möglichkeit der Übersetzung für diese Seite an

- noimageindex: Übernimm keine Bilder aus dieser Seite in den Google-Bilder-Index

- unavailable_after: Nach dem genannten Datum wird die Seite nicht mehr in den Suchergebnissen angezeigt

Beispiel des Robots-Meta-Tag mit mehreren Anweisungen

<meta name="robots" content="noindex, follow">.

Hier soll der Webcrawler die Webseite nicht indexieren, aber den Links folgen. So gelangt der Crawler nicht in eine „Sackgasse“.

Inhalte über Angaben im HTTP-Header sperren

Die Anweisungen, die über das Robots-Meta-Tag übermittelt werden können, lassen sich auch im HTTP-Header übertragen, was aber wohl nur in den seltensten Fällen implementiert wird. Dann würde der HTTP-Server die Anweisung in den HTTP-Header seiner Antwort aufnehmen, zum Beispiel so:

HTTP/1.1 200 OK

X-Robots-Tag: noindex, nofollow

…[Restlicher Header]

Vergleich von robots.txt und Robots-Meta-Tag

Vergleicht man die Möglichkeiten zum Sperren für Inhalte über das Robots-Meta-Tag mit denen der robots.txt-Datei, hat man zunächst das Gefühl, dass mit beiden Möglichkeiten dasselbe erreicht werden kann. Im Großen und Ganzen stimmt das zwar, aber nicht im Detail.

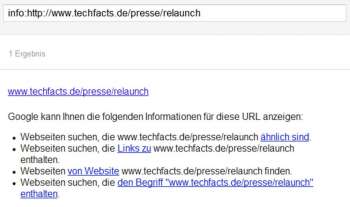

Die robots.txt-Datei verhindert, dass eine Website, ein Verzeichnis oder eine einzelne Seite vom Crawler einer Suchmaschine heruntergeladen wird. Sie verhindert aber nicht, dass die Webseite trotzdem in den Suchmaschinen-Index aufgenommen wird. Da der Crawler aber keine Informationen über die Seite liefern kann bzw. soll, sieht das Suchmaschinen-Ergebnis in der Regel „leer“ aus (siehe Screenshot). Die Seite http://www.techfacts.de/presse/relaunch ist in der robots.txt-Datei gesperrt, aber es gibt dafür trotzdem einen Eintrag im Google-Index.

Das Robots-Meta-Tag hingegen erfordert, dass der Crawler die Seite zunächst herunterlädt, um dann dort das Tag zu finden. Dafür kann aber über das„Noindex“-Attribut verhindert werden, dass ein Eintrag im Google-Index angelegt wird.

Wer Inhalte konsequent sperren möchte, könnte also auf die Idee kommen, beide Methoden kombiniert zu benutzen. Das hat aber den Nachteil, dass der Crawler die Seite durch eine Sperrung in der robots.txt erst gar nicht herunterlädt. Und so kann er auch nicht die Anweisungen im Robots-Meta-Tag finden. Wer also verhindern möchte, dass eine Seite irgendwie im Google-Index erscheint, darf folgerichtig die Inhalte nicht über die robots.txt-Datei sperren.

robots.txt und Robots-Meta-Tag haben noch einen weiteren Unterschied: In der robots.txt-Datei kann man Inhalte für bestimmte Crawler sperren. So könnte man eine Website für Google zugänglich machen, aber für die russische Suchmaschine Yandex sperren. Diese Möglichkeit bieten die Robots-Meta-Tags nicht.

|

robots.txt |

Meta-Robots-Tag |

|---|---|

|

|

Seiten aus Google löschen

Inhalte in den Google-Index zu bekommen kann in Sekunden geschehen. Aber es kann Monate dauern, Inhalte aus dem Index zu löschen. Auch wer einen Inhalt über die robots.txt oder das Robots-Meta-Tag sperrt, wird leere Einträge oft noch Monate lang im Suchmaschinenindex finden können. In den meisten Fällen ist das kein Problem, aber manchmal eben doch – zum Beispiel wenn es rechtliche Streitigkeiten gibt, in deren Folge bestimmte Inhalte aus dem Internet und damit auch aus Google entfernt werden müssen.

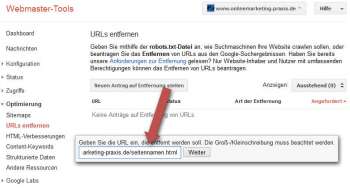

In diesen Fällen kann man die Google Webmaster-Tools nutzen. Hier gibt es die Möglichkeit, um einzelne Webseiten, ganze Verzeichnisse oder die Inhalte einer kompletten Subdomain aus dem Index zu löschen (siehe Screenshot).

Gelöscht werden aber nur Inhalte, die entweder über die robots.txt-Datei oder über Robots-Meta-Tags gesperrt werden. Die Löschungen werden in der Regel innerhalb weniger Stunden umgesetzt.

Weitere Tools

Google bietet übrigens über seine Google Webmaster-Tools noch weitere interessante Möglichkeiten in Bezug auf das Sperren von Inhalten.

So gibt es die Funktion „Abruf wie durch Google“, mit der man eine Webseite durch Google herunterladen lassen kann. Wenn die Seite gesperrt ist wird das auch direkt angezeigt (siehe Screenshot). Man kann so prüfen, ob das Sperren bestimmter Webseiten korrekt erkannt wird.

So gibt es die Funktion „Abruf wie durch Google“, mit der man eine Webseite durch Google herunterladen lassen kann. Wenn die Seite gesperrt ist wird das auch direkt angezeigt (siehe Screenshot). Man kann so prüfen, ob das Sperren bestimmter Webseiten korrekt erkannt wird.

Auch gibt es in den Webmaster-Tools unter dem Punkt „Status > Blockierte URLs“ die Möglichkeit, die Inhalte einer robots.txt-Datei im Original zu überprüfen oder sie temporär zu verändern und dann bestimmte URLS einzugeben. Google überprüft dann, welche der URLs durch welche Anweisung gesperrt werden.

Leider hat Google Webmaster-Tools den robots.txt-Generator eingestellt. Aber im Internet gibt es eine Vielzahl solcher Generatoren wie den robots-txt-Generator.

Fazit

|

SEMINAR-TIPP ZUR WEITERBILDUNG |

|---|

Zu diesem Thema bietet unser Kooperationspartner eMBIS Seminarangebote. Zu diesem Thema bietet unser Kooperationspartner eMBIS Seminarangebote. |

Das Sperren von Inhalten ist gar nicht so einfach. Je nachdem, welches Ziel man erreichen möchte, sollte man die robots.txt-Datei nutzen oder ein Robots-Meta-Tag in die eigenen Seiten einbauen. Mithilfe der Google Webmaster-Tools lässt sich das auch noch sehr gezielt überprüfen, damit es dabei keine ungewollten Schäden gibt. Und wer Seiten aus Google löschen möchte, findet auch hierfür die Lösung in den Google Webmaster-Tools.

Über den Autor

Markus Hövener ist Chefredakteur des Magazins suchradar und geschäftsführender Gesellschafter der Suchmaschinen-Marketing-Agentur Bloofusion Germany.